Exploitez vos données et automatisez vos processus grâce à nos solutions d’IA générative et nos agents autonomes intelligents.Depuis quelques mois, l’Intelligence Artificielle générative s’impose comme une révolution technologique majeure. Au-delà de l’effet de mode, elle offre des opportunités concrètes pour accélérer et optimiser les projets data, de la collecte des données jusqu’à leur exploitation décisionnelle. Les décideurs (CIO, CDO, CTO…) voient émerger une promesse claire : des données mieux exploitées, plus rapidement, pour un avantage compétitif décisif.

1. Collecte et ingestion des données : l’IA au service du data engineer

La première étape d’un projet data consiste généralement à collecter, ingérer et centraliser les données provenant de différentes sources. C’est le domaine de prédilection du Data Engineer, souvent en collaboration avec le Data Steward qui veille à la qualité et à la conformité des données collectées. Traditionnellement, cette phase peut être longue et fastidieuse : il faut développer des connecteurs vers des APIs ou bases de données, écrire des scripts d’ETL (Extract-Transform-Load) pour intégrer les données dans un data warehouse, et documenter l’origine et le schéma de ces données.

L’IA générative change la donne en automatisant et accélérant ces tâches techniques. Par exemple, un data engineer peut décrire en langage naturel la source de données à connecter et les transformations souhaitées, et l’IA générera automatiquement le code pour effectuer cette ingestion. Des outils de type copilot basés sur des modèles génératifs peuvent suggérer du code Python ou SQL prêt à l’emploi pour extraire et charger les données, réduisant drastiquement le temps de développement.

Un cas d’usage concret : l’automatisation du mapping de données hétérogènes. Relier entre elles deux sources de données différentes (par exemple l’ERP et le CRM de l’entreprise) demande d’identifier quelles entités ou clés correspondent – un travail manuel traditionnellement long et sujet à erreurs. Ici, un agent d’IA peut analyser les schémas et contenus des deux sources et proposer automatiquement les correspondances. Ce type d’agent autonome accélère l’intégration de nouvelles sources et garantit une meilleure cohérence.

Avec des solutions comme DUKE, la plateforme de DATANALYSIS, vous pouvez connecter vos données en quelques clics, éliminant la complexité technique pour obtenir rapidement des données exploitables.

2. Préparation et qualité des données : un bond en avant pour le data steward

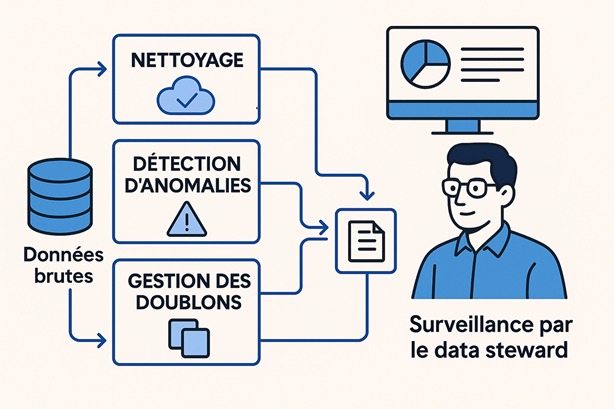

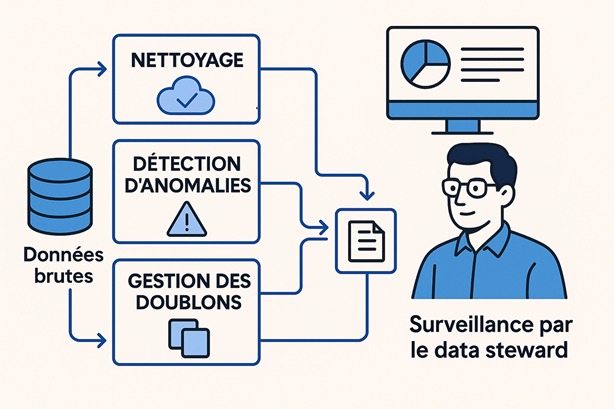

Une fois les données brutes ingérées, il faut passer par la phase cruciale de préparation, de nettoyage et de mise en qualité des données. Dans un projet classique, cette phase mobilise le data engineer et surtout le Data Steward, gardien de la qualité et de la gouvernance des données. Leur mission : dédoublonner, gérer les valeurs manquantes, uniformiser les formats et documenter les jeux de données.

L’IA générative excelle dans ces tâches répétitives et vient libérer les experts humains de ce fardeau. Par exemple, un modèle d’IA peut détecter automatiquement les anomalies, signaler les doublons et proposer des corrections pour normaliser les données. Ce type d’automatisation permet au data steward de se concentrer sur des tâches à plus forte valeur ajoutée, comme définir des règles de gestion de données et superviser les processus de contrôle qualité.

3. Analyse exploratoire et Business Intelligence : le copilote du data analyst

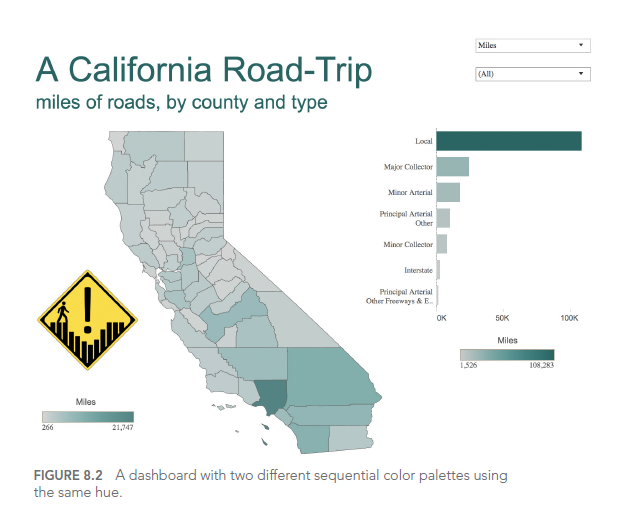

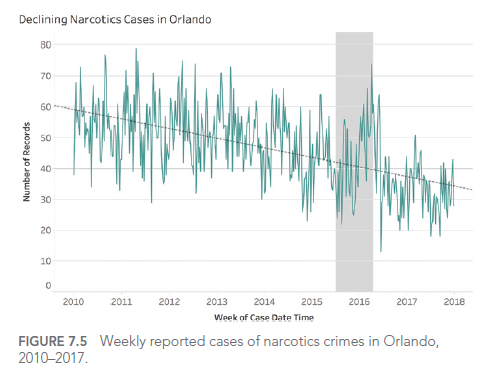

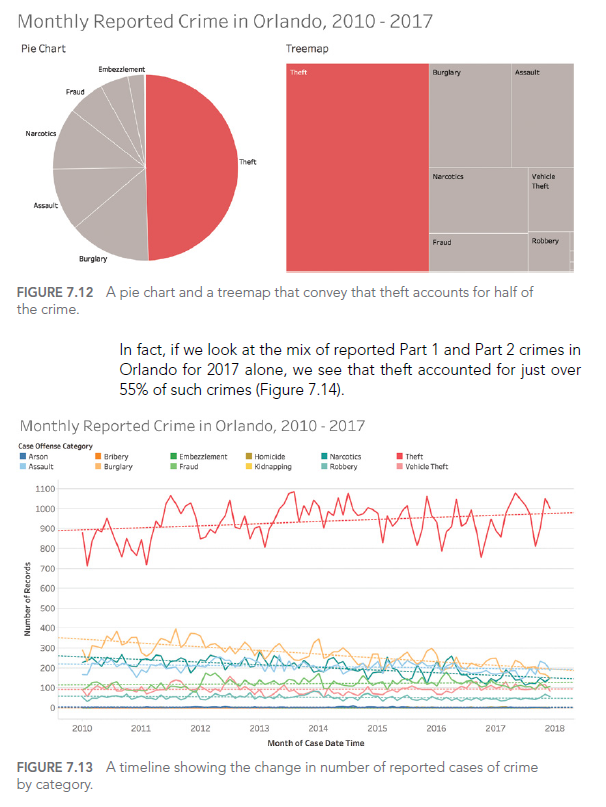

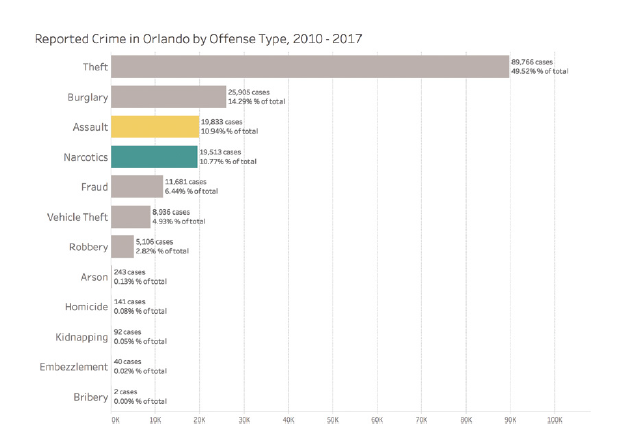

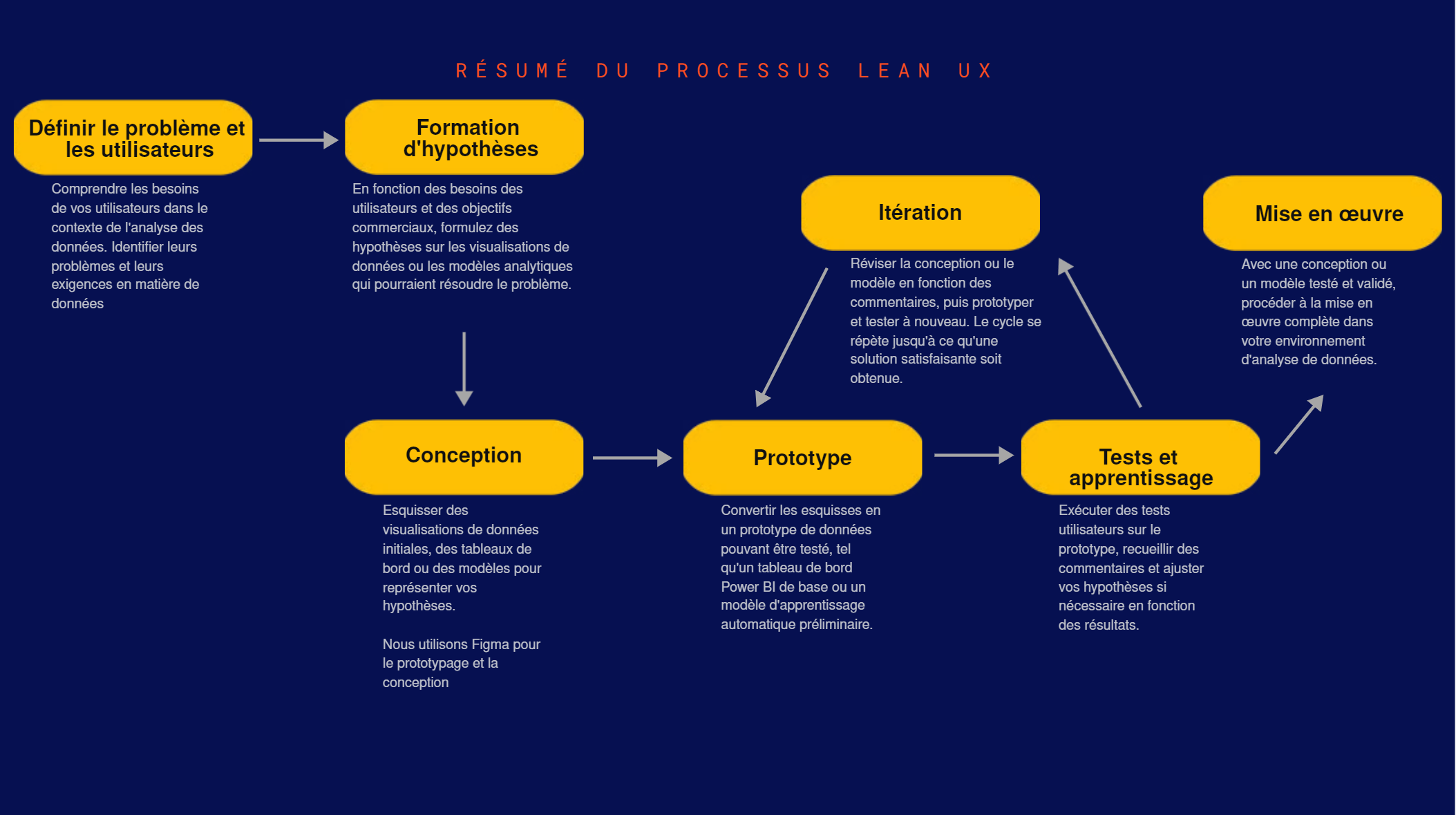

Quand les données sont prêtes, le Data Analyst intervient pour transformer ces données en insights actionnables. Traditionnellement, l’analyse exploratoire et la création de rapports pouvaient prendre des jours. L’IA générative, combinée à des interfaces conversationnelles, permet aujourd’hui de poser des questions en langage naturel et d’obtenir des réponses immédiates sous forme de graphiques ou de textes explicatifs.

Grâce à cette assistance, l’analyste peut se concentrer sur des analyses plus complexes, tandis que l’IA se charge de générer automatiquement des rapports et des visualisations. Cela améliore non seulement l’efficacité, mais permet aussi aux décideurs d’accéder rapidement aux informations nécessaires pour prendre des décisions éclairées.

4. Modélisation avancée et Data Science : un catalyseur pour le data scientist

Au-delà de l’analyse descriptive, de nombreux projets data incluent une dimension prédictive ou d’intelligence artificielle. Ici, le Data Scientist intervient pour concevoir, entraîner et déployer des modèles de Machine Learning. L’IA générative offre un soutien précieux en générant automatiquement du code et en proposant des solutions pour le prétraitement des données.

Par exemple, en décrivant simplement son besoin, le data scientist peut obtenir un prototype de script optimisé pour entraîner un modèle de classification ou de prédiction. Cela réduit considérablement le temps passé sur les tâches répétitives et permet de se concentrer sur l’innovation et l’optimisation des modèles.

L’IA générative ne remplace pas la créativité humaine, mais l’amplifie, offrant aux data scientists un véritable catalyseur pour accélérer l’innovation et améliorer la qualité des modèles déployés.

5. Déploiement, monitoring et consommation : vers des pipelines autonomes de bout en bout

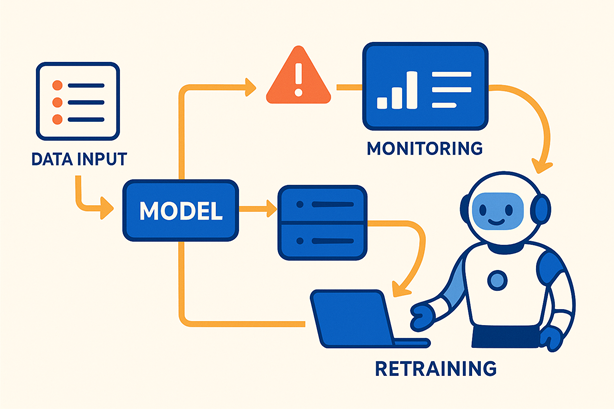

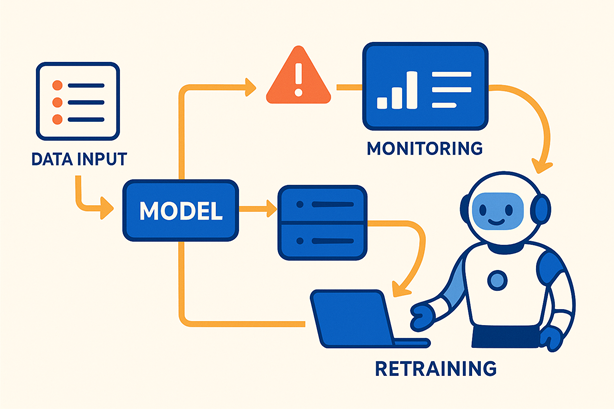

La dernière étape d’un projet data est la mise en production des solutions développées et leur exploitation par les utilisateurs finaux. Cette phase mobilise des équipes techniques pour le déploiement et la surveillance continue, ainsi que des utilisateurs métiers qui consomment ces analyses pour prendre des décisions stratégiques.

L’IA générative intervient ici en automatisant le déploiement et le monitoring des modèles. Par exemple, un agent autonome peut surveiller en temps réel la performance d’un modèle, détecter des anomalies et déclencher des procédures de réentraînement si nécessaire. Pour les utilisateurs, l’IA permet d’accéder à des tableaux de bord interactifs et personnalisés, transformant l’expérience de la donnée en une interaction dynamique et fluide.

Conclusion : Passez à l’action avec DATANALYSIS et DUKE

L’IA générative transforme en profondeur la manière dont les projets data sont conduits. Du data engineer assisté par des agents autonomes au data scientist propulsé par des outils d’analyse avancée, chaque étape est optimisée pour offrir un avantage compétitif décisif.

Chez DATANALYSIS, nous avons intégré ces innovations dans DUKE, notre plateforme unifiée Data & IA Générative, pour permettre aux entreprises de connecter, préparer, analyser et exploiter leurs données en toute simplicité. Nos solutions vous permettent de réduire le délai insight-décision, d’améliorer la qualité des données et de stimuler l’innovation au sein de vos équipes.

Vous souhaitez découvrir comment l’IA générative peut transformer vos projets data et offrir un avantage concurrentiel à votre entreprise ? Planifiez dès aujourd’hui une consultation avec un expert de DATANALYSIS et propulsez votre organisation vers l’avenir.