Bien démarrer avec la Business Intelligence: conseils pratiques

« La sagesse consiste à extraire de l’or des données brutes ; avec une Business Intelligence bien affûtée, chaque information devient une pépite. »

Cet adage résumé parfaitement le potentiel de la BI en prenant soin de suivre quelques conseils pratiques. Les mines d’or d’informations existantes permettent aux entreprises d’en faire des pépites d’or façonnées à leur image.

Définition

La Business Intelligence (BI) est un ensemble de processus, technologies et outils utilisés pour collecter, analyser, interpréter et présenter des données afin de fournir des informations exploitables aux décideurs et aux parties prenantes d’une organisation. L’objectif principal de la BI est d’aider les entreprises à prendre des décisions stratégiques en se basant sur des données fiables et pertinentes.

La BI est largement utilisée dans de nombreux domaines de l’entreprise, tels que la gestion des finances, la gestion des ressources humaines, le marketing, les ventes, la logistique et la chaîne d’approvisionnement, entre autres. En résumé, la Business Intelligence vise à transformer les données en connaissances exploitables pour améliorer les performances globales d’une organisation.

Avant de voir les conseils pratiques, examinons les éléments qui définissent ce qu’est la BI. Pour mettre en pratique la BI au sein de son entreprise, il existe 5 principales étapes qu’il faut suivre pour mener à bien une BI pertinente et efficace.

|

Collecte de données |

Les données sont collectées à partir de diverses sources internes et externes à l’entreprise, telles que les bases de données transactionnelles, les applications métier, les médias sociaux, les sondages clients, etc. |

|

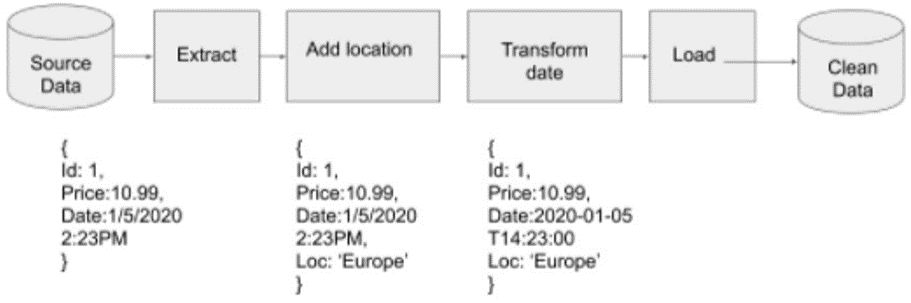

Nettoyage et transformation des données |

Les données collectées sont nettoyées, normalisées et transformées en un format compatible pour l’analyse. Cela implique souvent l’élimination des doublons, la correction des erreurs et la normalisation des formats de données. |

|

Analyse des données |

Les données sont analysées à l’aide de diverses techniques telles que l’analyse statistique, l’exploration de données, les modèles prédictifs et les algorithmes d’apprentissage automatique pour identifier des tendances, des modèles et des insights. |

|

Visualisation des données |

Les résultats de l’analyse sont généralement présentés sous forme de tableaux de bord, de rapports, de graphiques et d’autres visualisations interactives pour faciliter la compréhension et la prise de décision. |

|

Diffusion des informations |

Les informations obtenues sont partagées avec les décideurs et les parties prenantes à travers l’organisation, leur permettant ainsi de prendre des décisions éclairées basées sur des données fiables. |

CONSEILS PRATIQUES

Maintenant que nous savons globalement ce qu’est la BI dans sa définition, n’oublions pas que démarrer avec la Business Intelligence (BI) peut être un défi, mais avec une approche stratégique et des conseils pratiques, vous pouvez mettre en place une infrastructure efficace pour votre entreprise.

Voici quelques conseils pratiques pour bien initier une Business Intelligence pertinente et efficace.

Clarifiez vos objectifs

Avant de commencer à mettre en œuvre la BI, identifiez clairement les objectifs commerciaux que vous souhaitez atteindre. Que ce soit pour améliorer la prise de décision, optimiser les processus métier ou mieux comprendre vos clients, des objectifs clairs vous aideront à orienter vos efforts.

Commencez par les bases

Ne cherchez pas à tout faire d’un coup. Commencez par des projets pilotes ou des initiatives spécifiques pour vous familiariser avec les concepts et les outils de la BI. Cela vous permettra également de mesurer rapidement les résultats et de vous ajuster en conséquence.

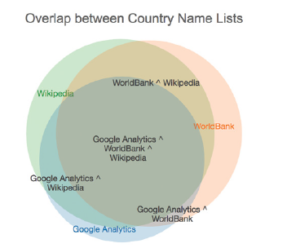

Identifiez vos sources de données

Identifiez les sources de données internes et externes à votre organisation. Cela peut inclure des bases de données transactionnelles, des feuilles de calcul, des systèmes CRM, des outils de marketing en ligne, etc. Assurez-vous que les données que vous collectez sont fiables, complètes et pertinentes pour vos objectifs.

Nettoyez et préparez vos données

La qualité des données est essentielle pour une BI efficace. Mettez en place des processus pour nettoyer, normaliser et préparer vos données avant de les analyser. Cela implique souvent d’éliminer les doublons, de corriger les erreurs et de normaliser les formats de données.

Choisissez les bons outils

Il existe de nombreuses solutions de BI sur le marché, alors faites des recherches pour trouver celles qui correspondent le mieux à vos besoins. Considérez des facteurs tels que la facilité d’utilisation, la capacité à gérer de grands ensembles de données, l’intégration avec vos systèmes existants et le coût.

Formez votre équipe

Assurez-vous que votre équipe est formée à l’utilisation des outils de BI et à l’interprétation des données. La BI est un outil puissant, mais son efficacité dépend de la capacité de votre équipe à l’utiliser correctement.

Communiquez et collaborez

Impliquez les parties prenantes dès le début du processus de mise en œuvre de la BI. Leur soutien et leurs commentaires seront essentiels pour garantir le succès à long terme de votre initiative BI.

Commencer petit et évoluer

Ne cherchez pas à mettre en œuvre toutes les fonctionnalités de BI en même temps. Commencez par des projets pilotes ou des initiatives spécifiques, puis étendez progressivement votre utilisation de la BI en fonction des résultats obtenus.

Impliquer les parties prenantes

Impliquez les parties prenantes dès le début du processus de mise en œuvre de la BI. Leur soutien et leurs commentaires seront essentiels pour garantir le succès à long terme de votre initiative BI.

Mesurez et ajustez

Suivez les performances de votre BI et mesurez son impact sur votre entreprise. Utilisez ces informations pour identifier les domaines d’amélioration et apporter des ajustements à votre stratégie de BI au fil du temps.

En suivant ces conseils pratiques initiaux, vous pouvez bien démarrer avec la Business Intelligence et commencer à tirer parti de vos données pour prendre des décisions éclairées et stimuler la croissance de votre entreprise

CONCLUSION

Un projet de Business Intelligence (BI) est considéré comme réussi lorsqu’il parvient à fournir de la valeur ajoutée à l’entreprise en répondant à ses objectifs commerciaux de manière efficace et efficiente. Voici quelques indicateurs clés qui peuvent définir un projet de BI réussi :

Alignement avec les objectifs commerciaux : le projet de BI doit être aligné sur les objectifs stratégiques de l’entreprise. Il doit contribuer à améliorer la prise de décision, à optimiser les processus métier, à accroître la rentabilité ou à renforcer la compétitivité de l’entreprise.

Utilisation efficace des données : un projet de BI réussi utilise efficacement les données pour fournir des informations exploitables. Cela implique de collecter, nettoyer, analyser et présenter les données de manière appropriée pour répondre aux besoins de l’entreprise.

Adoption par les utilisateurs : les utilisateurs finaux doivent adopter les outils de BI et les utiliser de manière régulière pour prendre des décisions. Un projet de BI réussi est celui qui répond aux besoins des utilisateurs et qui est facile à utiliser et à comprendre.

Amélioration des performances : un projet de BI réussi se traduit par une amélioration des performances de l’entreprise. Cela peut se manifester par une augmentation des ventes, une réduction des coûts, une amélioration de la productivité ou toute autre mesure de la performance pertinente pour l’entreprise.

Retour sur investissement (ROI) positif : un projet de BI réussi génère un retour sur investissement positif pour l’entreprise. Cela signifie que les avantages obtenus grâce à l’utilisation de la BI dépassent les coûts de mise en œuvre et de maintenance du projet.

Évolutivité et flexibilité : un projet de BI réussi est capable de s’adapter aux besoins changeants de l’entreprise et d’évoluer avec elle. Il doit être suffisamment flexible pour prendre en charge de nouveaux besoins, de nouveaux types de données ou de nouveaux scénarios d’utilisation.

Soutien et engagement de la direction : un projet de BI réussi bénéficie du soutien et de l’engagement de la direction de l’entreprise. La direction doit reconnaître la valeur de la BI et fournir les ressources nécessaires pour soutenir le projet tout au long de son cycle de vie.

En résumé, un projet de BI réussi est celui qui contribue à atteindre les objectifs commerciaux de l’entreprise en utilisant efficacement les données pour prendre des décisions éclairées. Il est caractérisé par son alignement avec les objectifs de l’entreprise, son adoption par les utilisateurs, son impact positif sur les performances de l’entreprise et son retour sur investissement positif.