Organisation Data-Driven : Quoi ? Comment ? // S2E2

Lors du premier épisode de cette mini-série, nous avons vu les avantages concurrentiels des organisations DATA DRIVEN dans une période complexe et incertaine comme celle que nous vivons actuellement.

Mais, qu’est ce qui caractérise une entreprise DATA-DRIVEN ?

Après avoir défini ce terme et nous allons vous partager quelques questions que vous pouvez vous poser pour savoir si votre organisation/votre équipe profitent pleinement du nouveau pétrole de l’économie.

1. Etre Data-Driven : kezako ?

Déf.

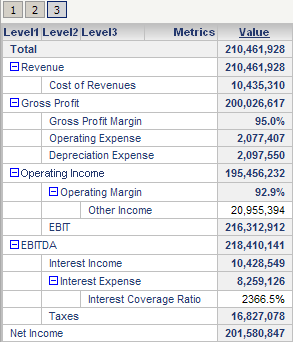

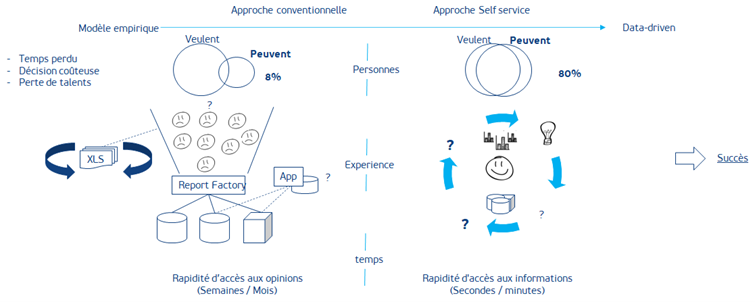

Être DATA DRIVEN cela veut dire qu’au sein d’une organisation les données sont utilisées ACTIVEMENT, par tous, tous les jours et pour répondre à la majorité des questions opérationnelles et stratégiques qui peuvent être posées pour découvrir de nouvelles informations et prendre des décisions. Cela implique donc d’avoir les outils, les compétences, les processus et les rôles qui permettent à tous de naviguer dans les données sans idées préconçues pour générer de nouvelles informations éclairées.

Eléments clés d’une organisation DATA DRIVEN :

- Ceux qui ont besoin d’utiliser les données dans leur tâche pour prendre de meilleures décisions peuvent le faire par eux-mêmes en ayant accès aux bonnes données et aux bons outils

- Les outils mis à disposition doivent être suffisamment simples et ergonomiques pour permettre des usages adaptés au rôle, profil et niveau de compétences des opérateurs métiers

- C’est par l’exploration et l’analyse des données que l’on identifie les bonnes informations et les bonnes décisions à prendre, même si cela peut être parfois contre-intuitif

- Les informations générées peuvent être communiquées rapidement et simplement aux managements et aux autres parties prenantes

- L’organisation des équipes permet un fonctionnement agile et l’utilisation quotidienne des outils analytiques

- De nouvelles données peuvent être rendues simplement accessibles pour valider leur intérêt, réaliser des analyses et des études, en attendant qu’elles soient intégrées à une plateforme transverse sur leur intérêt est confirmé.

Ce qu'une organisation DATA DRIVEN n'est pas :

Ce type de fonctionnement s’oppose aux organisations qui travaillent de manière empirique : j’ai une hypothèse sur mon activité, mon environnement, mes clients et j’espère trouver une réponse dans les rapports qui me sont fournis de façon hebdomadaire et mensuelle. Le cas échéant, je peux demander à une équipe dédiée de créer un nouveau reporting pour tenter d’affirmer ou d’infirmer mes hypothèses.

Ingrédients d'une organisation empirique :

- L’organisation des équipes est très verticale. L’accès aux données (souvent limité par les compétences techniques nécessaires) se concentre au niveau d’un seul service ; centre de compétence BI, DSI etc.

- Les opérateurs métiers doivent donc définir des hypothèses avant de soumettre une demande de création d’un rapport adapté pour vérifier la validité de celles-ci ; et attendre la construction de la solution pour commencer à prendre des décisions

- Les équipes analytiques recevant des demandes de toutes parts, les temps de réponses sont souvent très longs et les problématiques métiers deviennent obsolètes au moment où les développements sont achevés

- Les équipes opérationnelles développent des solutions de contournement pour trouver des réponses à leur problématiques (souvent par l’entremise de rapports manuellement générés sous Excel)

- La mise à disposition de nouvelles données pour répondre aux questions sur de nouveaux périmètres demande de passer par un processus lent, lourd et complexe de validation et de développement avant d’être enfin effectif.

2. Votre organisation est-elle DATA-DRIVEN ?

Votre équipe / votre entreprise utilise-t-elle les données de la manière la plus efficiente ? Rassurez-vous, cela ne nécessite pas (obligatoirement) de forts investissements dans de nouvelles technologies. Il s’agit d’avoir une organisation adaptée, des équipes aculturées aux données et des processus afin de prendre des décisions éclairées dès qu’une information pertinente est générée.

Et sur le terrain ?

1.Vous menez vos réunions avec vos équipes, votre management en argumentant vos décisions majoritairement par des exemples issus de votre entourage proche ou d’informations récoltées dans des publications extérieures à votre organisation?

- Votre approche est donc plutôt empirique. En effet, si votre cousine est fan d’un certains types de produits ou que vous avez vu un article (même d’une source de référence) décrivant le comportement des millénials dans certaines circonstances, cela ne veut pas dire qu’il s’agit d’éléments valides au regard de l’activité de votre organisation. Il est même possible que parfois ce type d’exemple ou d’anecdote ne soit pas du tout représentatif de votre marché, de votre public ou de votre environnement.

2. Vos services marketing, financiers, ventes, logistiques ne communiquent pas les données relatives à leurs activités entre eux ?

- Malheureusement vous êtes face à des silos organisationnels et cela est clairement un des signes attestant que votre organisation n’est pas DATA DRIVEN. Être DATA DRIVEN cela implique (dans le respect de certaines règles d’accès et de sécurité bien entendu) de partager les informations entre les services pour avoir toutes les cartes en main et prendre ainsi les meilleures décisions possibles.

3. Une majorité de vos employés sont capables d’accéder aux bonnes données et de faire les analyses qui sont nécessaires à leur travail ; par exemple :

- Le responsable d’un rayon saura à tout moment explorer les données pour vérifier quels sont les produits les mieux vendus pour chaque catégorie dont il a la charge et ainsi réorganiser son espace commercial

- Un directeur de magasin pourra déclencher une promotion pour augmenter le trafic dans son magasin en accédant simplement à une analyse des horaires de ventes et des meilleures actions commerciales à mettre en œuvre pour augmenter la fréquence d’achat

Si vous êtes dans cette situation ou proche de celle-ci, bravo ! Votre organisation est probablement DATA DRIVEN. Vos équipes à tous les niveaux de l’organisation sont capables de travailler efficacement avec les données nécessaires à la prise de décision.

Ainsi, on dit qu’une organisation est DATA DRIVEN si elle s’est dotée des outils, des processus, des rôles qui lui permettent de prendre les bonnes décisions, rapidement, sans à priori ou hypothèses préconstruites. Ces décisions s’appuient sur l’environnement réel (contraintes, partenaires, clients, etc.) de l’organisation et permettent donc un meilleur retour sur investissement comparativement à des méthodologies empiriques.