OFFRE D’EMPLOI-CONSULTANT DATA ENGINEER H/F – CDI

En recherche d’un nouveau challenge ?

Votre mission :

Accompagner nos clients dans leurs projets de transformation numérique et d’analyse de données.

Partenaires majeurs des entreprises de l’océan Indien pour leurs projets autour de la donnée, Datanalysis dans le cadre de son expansion recrute un Data Engineer

Véritable actif stratégique des entreprises, la donnée est aujourd’hui au cœur des enjeux de performance économique et concurrentielle. Nos équipes maîtrisent parfaitement son cycle de vie et les leviers pour que cette donnée devienne une information précieuse. Pour nous aider à aller encore plus loin et pour offrir une expertise additionnelle à nos clients, nous recherchons un profil alliant expertises technologiques et savoir-faire métier pour participer à la réalisation des projets de Data.

Intégré dans une équipe de 17 consultants sénior spécialisés en BI Self-Service, en Data visualisation, Machine Learning et IA, votre poste vous amènera sur les tâches suivantes :

- Conception et mise en place de pipelines de données pour collecter, stocker et traiter les données chez nos clients

- Optimisation de la performance et de l’évolutivité des systèmes de stockage de données pour améliorer les processus de nos clients

- Mise en place de processus pour assurer la qualité des données et ainsi aider nos clients à prendre des décisions informées

- Collaboration avec les équipes de développement pour intégrer les données dans les applications de nos clients

- Mise en place de systèmes de surveillance pour assurer la disponibilité et l’intégrité des données pour nos clients

Vous aimez relever de nouveaux challenges. Vous savez faire preuve d’engagement pour réussir et évoluez aisément dans un environnement dynamique.

Vous vous intéressez naturellement à vos clients pour savoir dans quelle mesure vous pouvez les aider à résoudre leurs problèmes.

Vous possédez un bon esprit d’analyse et de synthèse, un excellent relationnel.

VOUS PROFITEREZ PLEINEMENT DE CE POSTE SI…

- Vous disposez d’une forte appétence pour les nouvelles technologies

- Expérience professionnelle dans la conception et la mise en place de pipelines de données pour des clients

- Connaissance des outils de stockage de données tels que Hadoop, Spark, et NoSQL pour les implémenter chez nos clients

- Connaissance des outils de gestion de données tels que Airflow, NiFi, ou Talend pour les implémenter chez nos clients

- Bonne connaissance de SQL et des bases de données relationnelles pour les implémenter chez nos clients

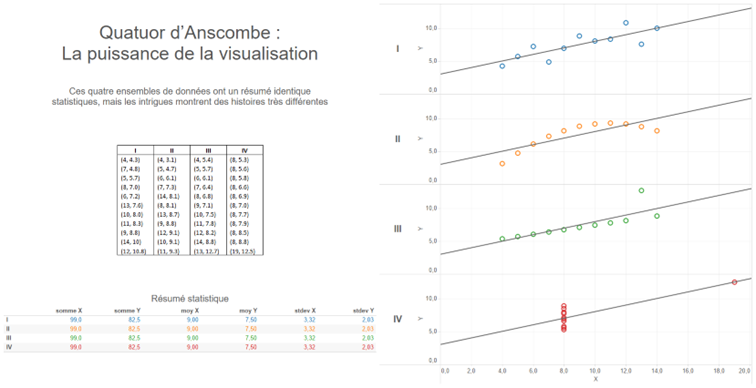

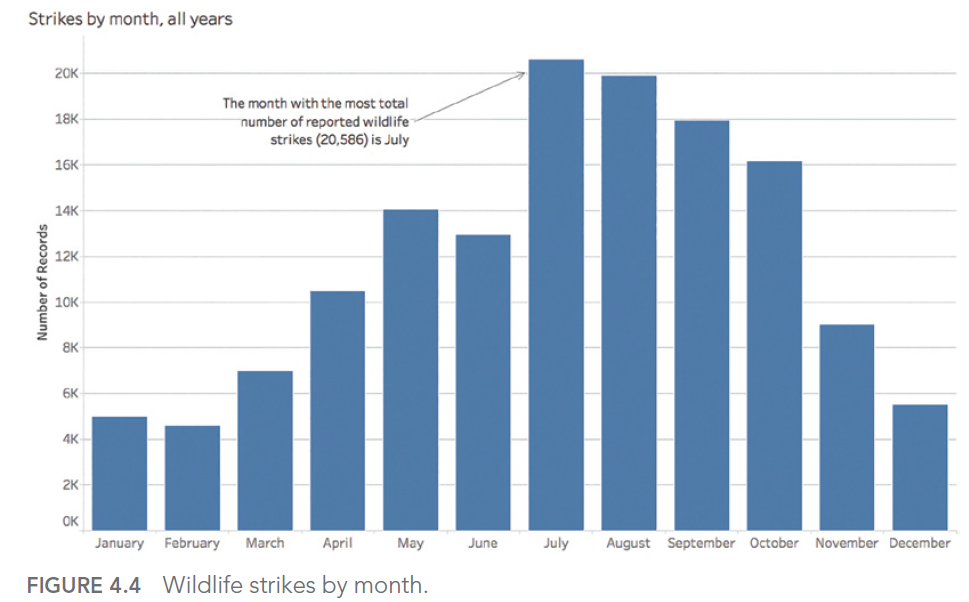

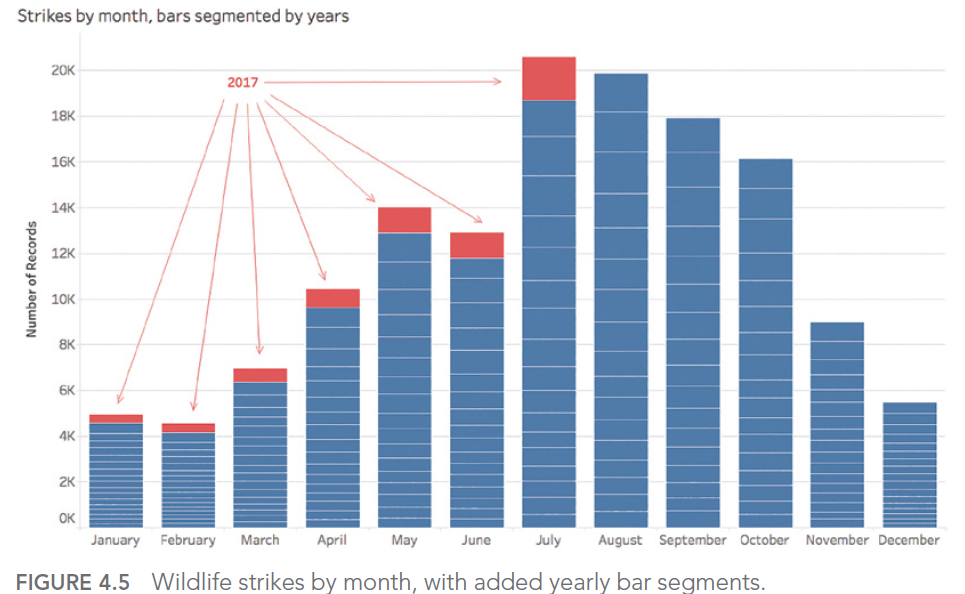

- Bonne connaissance des méthodes d’analyse de données pour les implémenter chez nos clients

- Bonne capacité à communiquer en anglais et en français pour travailler efficacement avec nos clients

- Vous faites également preuve également de capacités de gestion de projet, de recueil de besoins

La curiosité, l’intérêt pour le monde de la donnée, de la data visualisation et de l’IA sont des vrais plus.

Enfin, et surtout, vous êtes chaleureux, souriant et dynamique ! Vous aimez rendre service en apportant du soin à la qualité de votre travail.

OÙ TRAVAILLEREZ-VOUS ?

Le poste est basé à Saint Paul de la Réunion. Des déplacements sur toute l’île, et potentiellement sur l’île Maurice et Madagascar sont à prévoir.